Dieses Popup beim Seitenaufruf, das eine Anmeldung mit Google vorschlägt, nervt scheinbar nicht nur mich. Zum Glück lässt es sich leicht ausschalten.

Entweder man deaktiviert die Funktion in Chrome-Browsern unter der folgenden Einstellung (funktioniert auch mit Vivaldi):

chrome://settings/content/federatedIdentityApi

Oder man aktiviert in uBlock die EasyList unter Belästigungen/Annoyances.

Ich benutze den Google-Auth übrigens nur, wenn es gar nicht anders geht. Wer will schon seine Accounts an einen Google-Dienst binden und sich in unnötige Abhängigkeit begeben? Davon abgesehen ist man unflexibel, weil es oft nicht funktioniert, seine E-Mail-Adresse zu ändern. Ich habe kürzlich meine Gmail-Adresse aufgegeben. Die Webdienste, die ich per Google-Login nutze, bekommen davon jedoch kaum etwas mit und verwenden weiterhin die alte E-Mail-Adresse, ohne eine Änderungsmöglichkeit bereitzustellen.

Nach dem also das reTerminal E1002 E-Paper-Display angeschafft und aufgesetzt ist, wollte ich gerne das Nextcloud Kalender-Widget dort eingeblendet haben. Die erste zu nehmende Hürde betrifft die Authentifizierung. Man nimmt dafür nämlich nicht einfach die User-Credentials, sondern muss für den Benutzer neue Api-Credentials unter Persönliche Einstellungen → Sicherheit anlegen. Damit klappt es dann auch die Daten für das Kalender-Widget mit der URL https://{{domain}}/ocs/v2.php/apps/dashboard/api/v2/widget-items?widgets%5B%5D=calendar abzurufen. Die Api-Credentials muss man dafür als Basic-Auth in den Authorization-Header konfigurieren.

Letztlich braucht es nur noch das Liquid-Template, das ich mal hier verlinkt habe. Das Template rendert dann nur noch die Daten aus dem Abruf und stellt die abgerufenen Kalndereinträge dar. Das ganze sieht dann so aus.

Links

TRMNL Nextcloud-Calendar auf Github

Bastelprojekt TRMNL E-Paper-Device

Um Alexa abzulösen, habe ich mir den aktuellen Stand des Sprachassistenten von Home Assistant angesehen und war angenehm überrascht. Einzig die monatlichen 7,50 Euro für die Home Assistant-Cloud kommt mir für meine eher überschaubare Nutzung zu viel vor. Außerdem muss noch ein Abo nicht sein. Eine alternative bietet hier OpenAi, dass ich pro Anfrage bezahlen kann.

ATOM Echo Smart Speaker

Als erstes braucht es einen Smart-Speaker. Und weil es was günstiges sein soll, habe ich es mit dem

ATOM Echo ESP32 Smart Speaker versucht, den man einfach mit einem Home Assistant-Image flashen und direkt verwenden kann. Damit lässt sich so ziemlich alles zu steuern, was man in Home Assistant integrieren kann. Außerdem ist der ATOM Echo schön klein und kann gut versteckt werden. Außerdem könnte man ihn auch mit einer Powerbank betreiben, falls man zwar einen passenden Ort aber keine Steckdose in der Nähe hat.

Wyomingto to Openai-Proxy

Wenn man bei Einrichtung des Sprachassistenten auf die Home Assistant-Cloud verzichten möchte, kann man auch eine Anbindung an OpenAi oder eine Vielzahl anderer (auch lokal laufender) Möglichkeiten einrichten. Die Anbindung erfolgt per Wyoming Protocol. Ich habe mich für OpenAi entschieden, weil die lokalen Möglichkeiten bei mir keine ausreichend gutes Texttranskript für den Sprachassistenten hinbekommen haben. Der Proxy lässt sich einfach als Docker-Image starten.

services:

wyoming-openai:

image: ghcr.io/roryeckel/wyoming_openai:latest

environment:

STT_OPENAI_KEY: "dein_openai_key"

STT_OPENAI_URL: "https://api.openai.com/v1/audio/transcriptions"

STT_MODELS: "gpt-4o-mini-transcribe"

TTS_OPENAI_KEY: "dein_openai_key"

TTS_OPENAI_URL: "https://api.openai.com/v1/audio/speech"

TTS_MODELS: "gpt-4o-mini-tts"

TTS_VOICES: "alloy"

ports:

- "10300:10300"In Home Assistant nun unter Geräte das Wyoming Protocol einrichten und die Docker-Host mit Port 10300 eintragen. Nun kann man im Sprachassistenten die beiden Einstellung Text-to-Speech und Speech-to-Text mit dem über Wyoming Protocol bereitgestellten Dienste konfigurieren.

Aktivlautsprecher anschließen

Der kleine ATOM Echo ist mit dem kleinen Speaker leider sehr leise. Mit einem PCM5102A DAC Decoder Board lassen sich aber auch Aktivlautsprecher per Klinke anschließen.

| Pin (Modul) | Beschreibung | Verbindung am Atom Echo |

|---|---|---|

| vin | 5V Stromversorgung | 5V |

| gnd | Masse (Ground) | G |

| lrck | Left/Right Clock | G33 (lrck) |

| din | Data In | G22 (data out) |

| bck | Bit Clock | G19 (bclk) |

Links

$13 voice assistant for Home Assistant

Aliexpress M5Stack Offizielles ATOM Echo ESP32 Smart Speaker

Wyoming-Protokoll für OpenAi (Proxy)

PCM5102A DAC Decoder Board bei Aliexpress

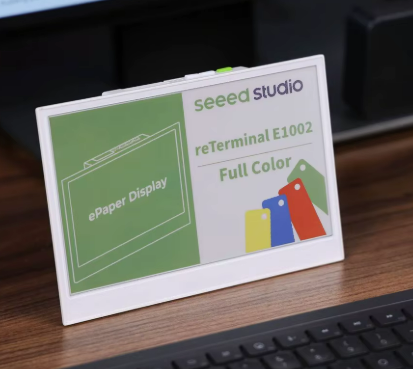

Um mich leichter erinnern zu können habe ich mir ein reTerminal E1002 E-Paper-Display angeschafft. Darauf will ich nahende Kalendereinträge aus meinem Nextcloud-Kalender und Nachrichten von meiner Ntfy-Instanz anzeigen. Und das alles Natürlich mit einem selbst gehosteten TRMNL-Server. Ich will ja keine Anbieter- oder Cloud-Abhängigkeit schaffen.

Die TRMNL-Firmware auf das reTerminal zu flashen ist so einfach, wie nichts. Auf der Hersteller-Seite findet sich ein Web-Flasher, den man einfach benutzen kann, um die aktuelle TRMNL-Firmware auf das Gerät zu bringen. Anschließend verbindet man sich per Wifi auf das Gerät und richtet die Netzwerkverbindung ein. Wenn man einen eignen TRMNL-Server betreiben will, muss man über die erweiterten Einstellungen noch die URL konfigurieren.

Am besten hat man den TRMNL-Server schon vorher bereitgestellt. Ich habe mich für TRMNL BYOS (PHP/Laravel)

entschieden, weil mir dieser zum jetzigen Zeitpunkt am aktivsten in der Entwicklung erscheint. Das Docker-Setup ist auch denkbar simpel. Wenn man nun noch Permit Auto-Join oben auf der TRMNL-Server Webseite aktiviert, verbindet sich das reTerminal E1002 automatisch nach dem Einschalten und erscheint als Device auf der TRMNL-Server Webseite.

Das war im Grunde schon der ganze Zauber. Das einzig störende ist zum einen das unschöne Flackern beim Aktualisieren des Displays und, dass das reTerminal E1002 noch nicht in Farbe angesteuert werden kann. Man hätte also einige Euro sparen können und anstelle dessen Schwarz-Weiss Modell E1001 kaufen können. Aber vielleicht tut sich da noch etwas. Bei dem ganzen TRMNL-Thema scheint gerade viel Bewegung drin zu sein und vielleicht kommt die Unterstützung von Farbe ja noch mit einem späteren Update.

Als nächstes geht es an die Einbindung des Nextcloud-Kalender. Grundsätzlich lässt sich jede erreichbare Datenquelle einbinden, wenn diese ein Json zurückgibt. Dazu kommt noch ein HTML-Template, mit dem die abgerufenen Daten gerendert und danach als Bilddatei an das E-Paper-Display gesendet werden. Das ganze nennt sich dann "Recipe" und weil das so einfach ist, gibt es davon auch jede Menge. Wie das mit TRMNL BYOS Laravel funktioniert, schreibe ich dann noch mal extra auf.

Auch nett: wenn man noch einen E-Book-Reader herumliegen hat, kann man auch einfach eine Trmnl-Firmware flashen und den Reader als Display benutzen. Das geht aktuell für

KOReader, Kindle, Nook und Kobo.

Sepecs reTerminal E1002

Kompatibel mit: Arduino/PlatformIO, ESP-IDF, ESPHome, Home Assistant, TRMNL, SenseCraft HMI

Mikrocontroller: ESP32-S3 Dual-Core mit 8MB PSRAM, 32MB SPI Flash

Display: 7,3-Zoll Full-Color E-Ink (E Ink Spectra 6), 800x480 Auflösung

Batterie: 2000 mAh integriert, bis zu 3 Monate Laufzeit im Tiefschlafmodus

Wireless: 2,4 GHz Wi-Fi 802.11 b/g/n, Bluetooth 5.0

Sensoren: Temperatur- und Feuchtigkeitssensor

Audio: 3 Mikrofone, Buzzer

Speicher: MicroSD-Karten-Slot (bis 32GB, FAT32)

Steuerung: 3 Tasten, Status-LED (grün), Lade-LED (rot)

Anschlüsse: USB-C (5V/1A Laden/Update), 8-Pin Expansion-Port (GPIO, I2C, VDD, GND)

Abmessungen: 176x120x53 mm (mit Ständer), 17 mm (ohne Ständer)

Links

In der Tat eine Sache, die ich beim Sammeln von Prompt-Teilen ja schon von alleine mache. Das Ganze ein bisschen zu systematisieren ist aber sicher auch eine gute Idee. Zumindest, wenn um Bild- oder Video-Generierung geht und man viele vergleichbare Ergebnisse in verschiedenen Variationen erhalten möchte. Man sammelt also Prompts für Stil, Licht, Kamera, Komposition, Farbe und Textur sowie Stimmung und kombiniert die dann fröhlich.

Bei promptlibrary.org findet man übrigens auch noch jede Menge Prompts, um der eigenen Inspiration einen Schubs zu geben.

Links

Ich mache nur gelegentlich etwas mit HTML. Und ebenso gelegentlich habe ich mit CSS zu tun. Weil ich aber die CSS-Selektoren aber alle paar Monate mal brauche und jedes Mal nachgucken muss, gibt es hier nun meine Gedächtnisstütze.

| Selektor | Beispiel-HTML | CSS | Erklärung |

|---|---|---|---|

| Element-Selektor | <p>Textabsatz</p> |

p { color: blue; } |

Wählt alle HTML-Elemente dieses Typs aus. In diesem Beispiel betrifft die Regel alle <p>-Tags. |

| Klassen-Selektor | <div class="highlight">Inhalt</div> |

.highlight { background-color: yellow; } |

Wählt alle Elemente mit dieser Klasse aus – unabhängig vom Elementtyp. |

| Element-Klassen-Selektor | <p class="info">Hinweistext</p> |

p.info { font-style: italic; } |

Wendet den Stil nur auf <p>-Tags mit der Klasse info an. Andere Elemente mit dieser Klasse werden nicht betroffen. |

| ID-Selektor | <h1 id="titel">Seitentitel</h1> |

#titel { text-transform: uppercase; } |

Spricht ein bestimmtes Element mit dieser ID an. IDs dürfen nur einmal pro Seite vorkommen. |

| Mehrere Selektoren | <p>Text</p><br><a class="link">Verweis</a> |

p, a.link { color: green; } |

Mehrere Selektoren werden durch ein Komma getrennt. Dieselbe Regel gilt somit für beide: alle <p>-Elemente und alle <a> mit der Klasse link. |

| Kombination von Selektoren | <div class="container"><br> <p>Absatz im Container</p><br></div> |

div.container p { font-weight: bold; } |

Diese Regel gilt nur für <p>-Tags, die sich innerhalb eines <div> mit der Klasse container befinden. Andere <p>-Elemente bleiben unverändert. |

Stellt man der KI die gleiche Frage, ist die Antwort immer ähnlich. Wer mehr kreativität möchte, sollte lieber gleich nach mehreren Antworten fragen. Das macht sich u.a. auch bei der Bildgenerierung nutzbar, weil man ein viel breiteres Spektrum an Stilen und mögliche Interpretationen der gleichen Sache bekommt. Einfach den folgenden Magic Prompt vor den eigenen Promptes setzen.

<instruction>

Generate 5 responses to the user query, each within a separate <response> tag. Each <response> must include a <text> and a numeric <probability>.

Randomly sample the responses from the full distribution.

</instruction>Links

Ein einzelner Prompt soll langweilige KI-Antworten verhindern

Ein kostenloser Test, der eine Website auf digitale Barrierefreiheit hin bewertet.

Ansonsten ist auch die WAVE Browser Extensions für lokale Tests eine feine Sache.

Als Umsteiger von TTRSS auf FreshRSS ist für mich immer noch ungewohnt, dass die Titelleiste bei längeren Artikeln nach dem Runterscrollen verschwindet. Dem ist mit einem CSS-Tweak Abhilfe zu schaffen. Wenn man das folgende User-CSS konfiguriert, bleibt die Titelzeile eines jeden Feedeintrags immer am oberen Rand haften. Das ist auch praktisch, weil man nun auch mit einem Klick auf den Titel auf die entsprechende Webseite des Feedeintrags gelangt. Ganz ohne wieder hochscrollen zu müssen.

.flux > ul.horizontal-list.flux_header {

position: sticky;

top: 0;

z-index: 5;

}Direkt bei Studio Ghibli gibt es insgesamt 400 Bilder, die man "Im Rahmen des gesunden Menschenverstands" verwenden darf. Da ist viel stimmungsvolles dabei.

Wer keine Mitarbeitergespräche führen kann oder will, ist ein schlechter Chef – dieser Aussage widerspricht Armin Trost. Der Professor für Personalmanagement fordert, das Standard-Instrument auf Herz und Nieren zu prüfen.

In seinem Buch “Unter den Erwartungen” erklärt Prof. Dr. Armin Trost, warum das jährliche Mitarbeitergespräch in modernen Arbeitswelten versagt.

Den beiden zentralen Aussagen, dass ein Mitarbeitergespräch in einer Künstlichen Situation statt findet und am Ende etwas in der Personalakte landet, kann ich ganz und gar nachvollziehen. Ich hätte es aber nicht so einfach ausdrücken können, wo dieses Unbehagen herrühert. Trotzdem zählt das Mitarbeitergespräch offenbar für viele Firmen einfach dazu. Da muss man halt durch. Warum diese Gespräche geführt werden und ob es einen messbaren Nutzen hat, ist ja auch oft zumindest fragwürdig.

https://www.cio.de/article/3679613/wenn-das-mitarbeitergespraech-schadet.html

Eine handverlesene Liste der besten deutschsprachigen Tech Podcasts zu relevanten Themen für Entwickler:innen, Tech-Leads und Nerds.

Sammlung urheberrechtsfreier Werke, die kostenlos weiterverwendet werden können.

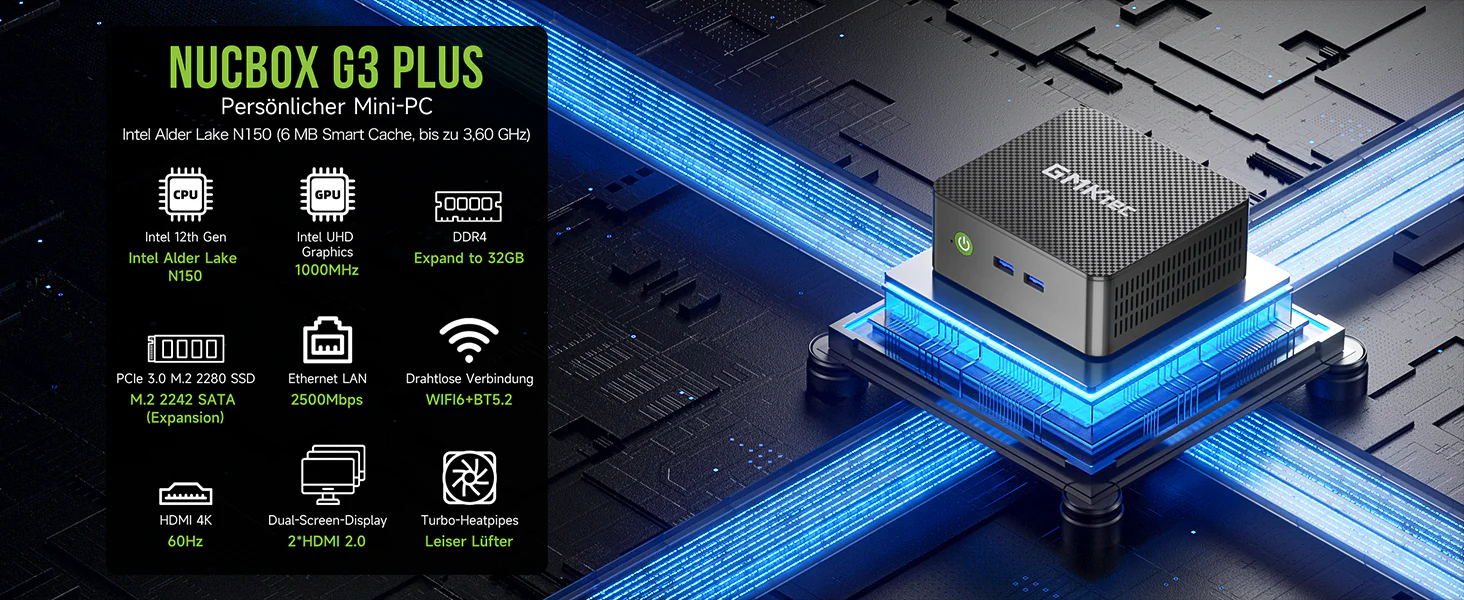

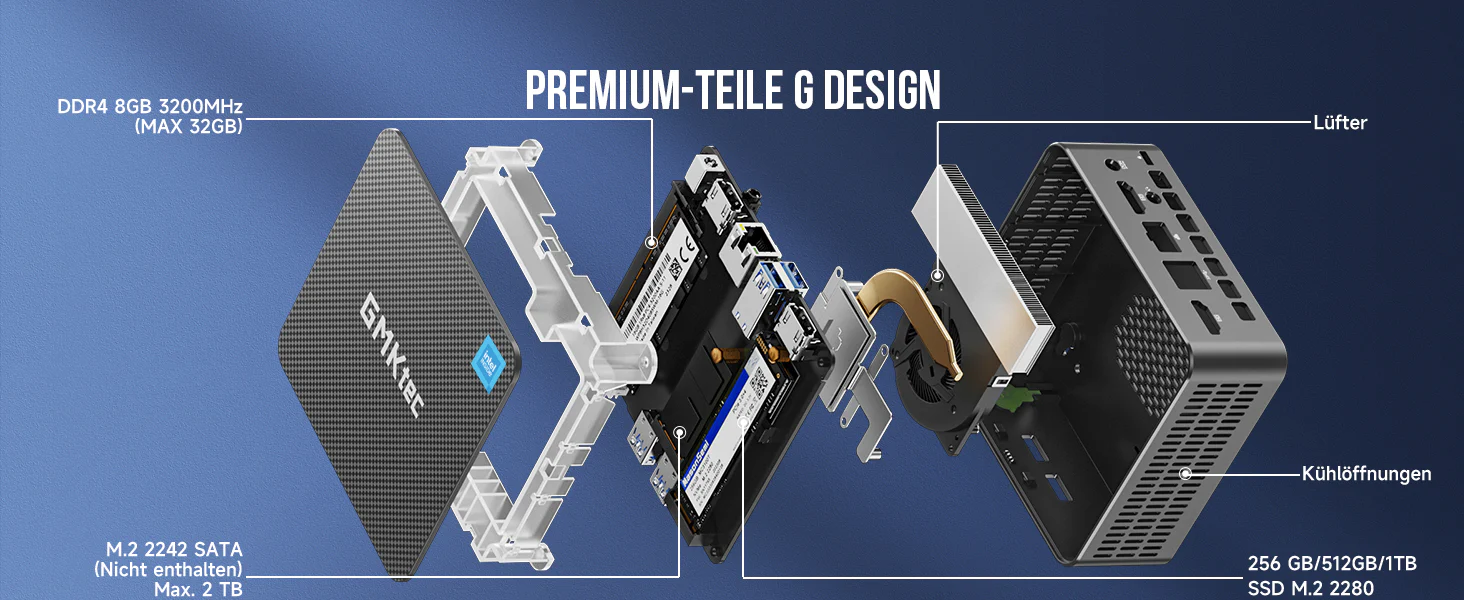

Um etwas mehr Schwung ins Homelab zu bekommen, habe ich mich nach knapp zwei Jahren für eine modernere Lösung entschieden und meinen HP T630 vorerst in den Vorruhestand geschickt. Gerade kostengünstig war die NucBox G3 Plus von GMKtec erhältlich.

Der erste Eindruck ist recht gut. Den Lüfter hört man nicht und die Kiste fühlt sich deutlich flotter an, als der HP T630. Einzig die Sache mit dem Powermanagement scheint mal wieder so ein Windows-Ding zu sein. Mit Ubuntu 24.04 kommt man auch mit im Bios aktivierten C-States und Low-Powerprofile nicht unter 12 Watt im Idle-Modus. Auch Powertop reißt da nichts raus. Da scheint man also wenig machen zu können.

Hardware-Spezifikationen

| Eigenschaft | Beschreibung |

|---|---|

| Geräteabmessungen | 114mm x 106mm x 42,5mm |

| CPU | Intel® Twin Lake N150, Quad-Core, 4 Threads, max. Turbo-Frequenz 3,6 GHz; 6 MB Cache; TDP 6W |

| GPU | GPU Name: Intel UHD Graphics 24 EUs (Alder Lake) |

| Speicher-Slot 1 | M.2 2280 NVMe (PCIe3.0) max. 2TB |

| Speicher-Slot 2 | M.2 2242 SATA max. 2TB |

| RAM | DDR4 3200 MT/s, SO-DIMM*1, Maximale Unterstützung bis zu 32GB |

| Grafikausgang | Dual-Display-Ausgang, 2*HDMI 2.0 (4K@60Hz), unterstützt bis zu 4096x2160 Auflösung |

| Anschlüsse | USB 3.2 (Gen1) 4, HDMI 2, 4096x2160@60Hz, 3,5mm Kopfhöreranschluss, Giga LAN (RJ45)1, 2500M/1000M/100M/10M |

| Wireless Network | WiFi 6, Realtek 8852BE 802.11a/b/g/n/ac/ax, Übertragungsgeschwindigkeit 1201Mbps, unterstützt bis zu 12 Geräte. BT 5.2 |

| Stromversorgung | Batterie: Eingebaute Knopfzellenbatterie. Netzteil: DC IN (5,5/2,5mm), 100-240V AC, 50/60Hz, Ausgang: 12V/3A |

| Betriebsumgebung | -10°C bis 45°C, 30% bis 90% Luftfeuchtigkeit |

Hardware Codec-Unterstützung

| Codec | Dekodieren | Enkodieren |

|---|---|---|

| h265 / HEVC (8 bit) | X | X |

| h265 / HEVC (10 bit) | X | X |

| h264 | X | X |

| VP8 | X | X |

| VP9 | X | X |

| AV1 | X | |

| AVC | X | X |

| VC-1 | X | |

| JPEG | X | X |

Boot-Keys

Boot-Menu und Bios-Setup bekommt man angezeigt, wenn man nach dem Einschalten die Escape-Taste drückt. Mit F7 kommt man direkt ins Boot-Menü.

Grafik-Treiber Ubuntu 24.04

Es gibt einige Berichte über einen fehlenden Intel Alder Lake-N Grafiktreiber im 6.8er Kernel, der von Ubuntu 24.04 LTS verwendet wird. Dem kann man mit einem aktuellen Kernel begegnen, der sich auch recht einfach mit dem Tool Mainline installieren lässt.

M.2 2280 SATA

Leider kann man nur eine Sata-SSD im 2242-Format verbauen. Allerdings gibt es für teure 20 Euro einen Extender der die SSD nach draußen verlegt. Damit lässt sich dann doch eine 2280er Sata-SSD betreiben.

Riser Extender M.2 NGFF B Key für M.2 SSDs vom SATA-Typ. Variable Länge

Mods aus dem 3D-Drucker

Der G3 Plus und der G3 haben das gleiche Gehäuse. Das ist praktisch, weil man dann diese Abdeckung benutzen kann, um zwei Sata-Ausgänge nach außen zu führen.

GMKtec G3 SFF SATA Lid

Produktbilder

Quelle: Produktfoto GmkTec

Links

Intel® Prozessor N150 6 MB Cache, bis zu 3,60 GHz

GMKtec NucBox G3 Plus – Mini-PC mit verbesserter Leistung und Intel Twin Lake N150

GMKtec Guides / How-to Tutorial

Eine Sammlung von Icons und Logos für selbst gehostete Dashboards und Dokumentation.

Als jemand, der mehrere Rechner und ein Smartphone verwendet, kommt mir der Anwendungsfall ziemlich häufig vor, dass ich eine Webseite oder eine Datei an ein anderes Gerät senden möchte. Dafür benutze ich bereits seit Langem die früher recht populäre Anwendung Pushbullet. Pushbullet bietet, wie ich finde, ein sehr gelungenes Browser-Plugin und natürlich eine Smartphone-App. Da ich jedoch weniger Daten in Cloud-Dienste schieben möchte, ist Pushbullet ein Kandidat, den ich gerne ablösen möchte.

Eine gute Open-Source-Lösung für Messaging ist Ntfy.sh, das sich auch selbst hosten lässt. Im Prinzip sendet man eine Nachricht und/oder eine Datei an einen beliebigen Kanal, und jeder Client, der auf diesem Kanal lauscht, erhält die Nachricht. Um zum Beispiel einen Weblink von meinem Smartphone an den Browser meines Notebooks senden zu können, benötigt man lediglich die Ntfy.sh-Smartphone App, die den Link an einen Kanal sendet, und eine Browseranwendung auf dem Notebook, über die man den Link empfangen kann. Ntfy.sh bietet auch eine Webanwendung, mit der das möglich ist. Ich hätte jedoch gerne den Link direkt als Browser-Tab geöffnet, was mich zur Entwicklung eines passenden Chrome-Plugins geführt hat.

Das gesamte Setup ist sehr einfach. Entweder hostet man ein eigenes Ntfy.sh oder verwendet die öffentliche Instanz unter gleichnamiger Url. Das Secret / Passwort beim Nachrichtenaustausch ist der Name des Kanals selbst. Man hat also nur Zugriff auf den Kanalinhalt, wenn man den Namen kennt. Wenn man die Server-Instanz selbst hostet, kann man jedoch auch eine Basic-Authentifizierung oder einen Secret-Token einrichten.

Hat man den Ntfy.sh-Server am Laufen, kann das Chrome-Plugin NtfyNewtabSubscriber in Betrieb genommen werden, um Nachrichten als neuen Browser-Tab zu empfangen. Im Plugin muss man nur noch die URL und den Kanalnamen eintragen (s. Bild), und schon lassen sich Nachrichten an den Browser senden. Für den Rückweg, also die Nachricht an das Smartphone, gibt es übrigens das Chrome-Plugin Send to Ntfy. Letzteres lässt sich auch aus dem Chrome-Store beziehen.

Konfiguration der NtfyNewtabSubscriberExtension

Wenn man es rudimentärer haben möchte, kann man anstelle der ganzen Apps auch einfach curl benutzen. Gerade weil es so einfach ist, ist Ntfy.sh ein Schweizer Taschenmesser für alles rund ums Messaging und damit ein flexibles Tool im Portfolie.

Links

- Ntfy.sh-Server

- Chrome Browser-Plugin NtfyNewtabSubscriber

- Chrome Browser-Plugin Send to Ntfy.

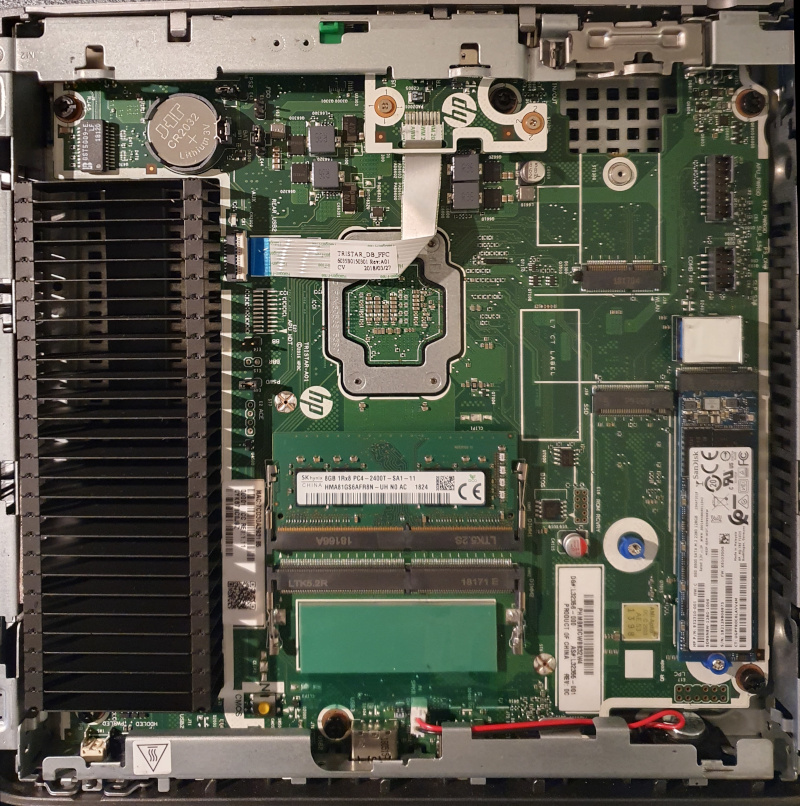

Vor etwa einem Jahr habe ich meinen Mietserver bei Netcup gekündigt uns hoste nun alles selbst. Auf einem Thin-Client. Genauer auf einem HP T630. So ganz konkret zum handeln gebracht hat mich das Video Gebrauchte Thin-Clients im Test

auf dem Heise-Youtube-Kanal Ct'3003. Inzwischen hat der Home-Server auch schon einige Upgrades erfahren. Um die Hardware soll es in diesem Shaare gehen.

Ein wichtiger Aspekt war für mich, dass das Gerät leise ist. Und das ist der T630 auch, weil er nämlich keinen Lüfter besitzt. Der zweite Punkt ist der Stromverbrauch. Ich habe im Betrieb eine Leistungsaufnahme von 11-13 Watt gemessen. Das ist leider mehr als ein vergleichbareres Gerät mit einem Intel J4105 Chipsatz, der etwa die Hälfte verbraucht, dafür aber in der Anschaffung teurer ist. Wenn man das durchrechnet kostet der T630, bei einem Strompreis von 33 pro kWh, etwa 30 Euro im Jahr. Das ist auf jeden Fall schon mal weniger, als ein angemieteter Server. Und weil der Anschaffungspreis des T630 am günstigsten war, ist es eben dieser geworden.

Hardware

Die Details kann man sich aus der QuickSpecs (PDF) herauslesen. Entscheidend finde ich folgende Infos.

Specs

- CPU AMD GX420-GI

- GPU AMD Radeon R7E

- RAM 2x SO-DIMM Slots, die man mit bis zu 2x16GB bestücken kann. Ich habe 1x16GB, was bisher mehr als genug ist.

- 2x m.2 SATA Slots

- 1x m.2 für einen Wifi/Bluetooth-Adapter

- 3x USB-A 3.0. Zwei an der Front und einer im Gehäuse, was kreative Einsatzmöglichkeiten bietet. Allerdings kann man vom internen USB-Port nicht booten.

- 4x USB-A 2.0. Zwei an der Front, zwei an der Rückseite.

- 2x DisplayPort 1.2. Leider kein HDMI dafür aber noch einen VGA-Port.

- 1x Gigabit RJ45 / LAN

RAM-Upgrade

Es genügen günstige DDR4 SODIMM / 1866Mhz RAM-Module mit 260 Pins. Es Funktionieren aber auch Riegel mit höherem Takt wie 2133Mhz, 2400Mhz, 2666Mhz, 2933Mhz oder 3200Mhz. Diese laufen dann aber nur mit 1866Mhz.

- Crucial-CT2K16G4SFRA32A (Amazon)

ECC-RAM

Der Chipsatz des T630 ist für den Betrieb von ECC-RAM geeignet. Das kann man im Bios leider nicht aktivieren, aber dafür direkt unter Linux mit

modprobe -v amd64_edac ecc_enable_override=1und zum testensudo dmesg | grep -i edac.

Wenn alles wunschgemäß aussieht, mit folgendem Befehl dauerhaft persistieren.sudo echo "options amd64_edac ecc_enable_override=1" >> /etc/modprobe.d/amd64_edac.conf

m.2 SATA SSDs nachrüsten

Die beiden m.2 Schnittstellen funktionieren nur mit SATA-SSDs. Man kann also keine NVME-SSDs verwenden. Ich habe eine Transcend M.2 SSD TS2TMTS830S eingebaut. Entscheidend für mich waren die langlebige MLC-3D-NAND-Flash-Bausteine.

Zweiten Netzwerk-Port nachrüsten

Zwar ist keine zweite Netzwerkschnittstelle vorgesehen, aber kann man den m.2 2230 Slot (Wifi-BT-Karte) dafür nutzen. Ein- oder mehrere USB3-Netzwerkadapter funktionieren aber auch. Tatsächlich ging das bei mir sogar überraschend stabil.

- M.2 a e Key 2,5g Ethernet LAN-Karte rtl8125b (Aliexpress)

- Einbauanleitung (Youtube)

- Einbauanleitung - How to install an extra NIC

Netzteil

Der T630 hat einen HP-Typischen, 7,4mm Netzstecker mit Smartpin. Das ist nervig, wenn man ein neues Netzteil beschaffen muss. Oft werden die Geräte auch besonders günstig ohne Netzteil angeboten. Besonders einfach geht es mit einem USB-C Adapter, der es erlaubt, jedes USB-C Netzteil, das 19-20V bei wenigstens 65 Watt liefert, anzuschließen. Auf diese Idee bin ich leider etwas zu spät gekommen.

Mods aus dem 3D-Drucker

- Schale für die Wandmontage (cults3d)

- Geräte-Ständer (cults3d) oder Geräte-Ständer (thingiverse)

- Adapter fuer zweite m.2 2280-Full-Size SSD (thingiverse)

Wärmeleitpaste erneuern

Links

Innenleben des HP T630

Your photos reveal a lot of private information. In this experiment, we use Google Vision API to extract the story behind a single photo.

Google nutzt künstliche Intelligenz, um hochgeladene Fotos detailliert zu analysieren. Dabei werden nicht nur offensichtliche Merkmale wie Alter oder Ort einer Aufnahme erfasst, sondern auch die Emotionen abgebildeter Personen. Vishnu Mohandas, ein ehemaliger Google-Mitarbeiter, betrachtet diesen Einsatz mit Skepsis und äußert Bedenken hinsichtlich des Datenschutzes und der möglichen Verwendungszwecke der gesammelten Informationen.

In diesem Zusammenhang wurde die Website Theyseeyourphotos.com ins Leben gerufen, um ein Bewusstsein dafür zu schaffen, welche Informationen durch solche Analysen preisgegeben werden können. Nutzer können dort beliebige Fotos hochladen und von Googles KI analysieren lassen. Die Ergebnisse sind sehr detailliert. Aber seht selbst. Das folgende Bild, das ich im Vorübergehen abgelichtet habe und auf dem auf ein Event hingewiesen wird, wird wirklich sehr ausführlich und korrekt beschrieben.

Foto, das für den Test hier herhalten musste

Germany. The poster advertises a "Ghibli Days Vol. 4 Merchandise Pop Up Shop" at the Pop Up Club Berlin. The foreground is dominated by the poster itself, featuring artwork of Totoro from the Studio Ghibli film, My Neighbor Totoro. In the background, reflections of buildings and some blurry details are visible through the glass window. The shop seems to be located in a residential or mixed-use area judging by the surrounding buildings. The poster mentions specific dates and times for the pop-up shop.

The photograph was taken on Saturday, November 30th, 2024 at around 3:09 PM using a Samsung Galaxy S24. No people are directly visible in the image, however, one could infer the presence of shopkeepers and customers who might have an interest in Japanese animation and merchandise. Their emotional state, racial, ethnic background, age, economic status, and lifestyle are unknown from just this image. The activities around this time could involve customers browsing or purchasing products from the pop-up shop. The reflection in the glass suggests that someone was taking a picture outside the shop at the same time.

The quality of the image is affected by the reflection on the glass of the shop's window. Some parts of the poster are harder to see because of the reflection. It's also possible to see some small particles of dust or dirt on the window itself, slightly obscuring the view. The lighting conditions seem average; not too bright nor too dark, suggesting it was taken during daylight hours. There is a small barcode QR code at the bottom right corner of the poster which customers could scan for additional information about the event.

Der Feedreader TTRSS ist seit Langem mein täglicher Begleiter, sowohl für News, Blogs als auch für alles, was mich interessiert und einen Feed hat. Einen CSS-Tweak benutze ich schon seit einiger Zeit, den ich nun weiter verbessern konnte.

Ich finde den Lesefluss nämlich generell angenehmer, wenn Textzeilen nicht zu lang sind. Es verbessert schlicht den Lesefluss, wenn man am Ende der Textzeile dieser nicht über die gesamte Bildschirmbreite zum nächsten Zeilenanfang folgen muss. Zeitungen machen das ganz klassisch mit mehreren nebeneinander stehenden Textblöcken. Ich finde das super. Deshalb habe ich das schon seit Ewigkeiten für meinen Feedreader TTRSS so eingerichtet.

Einfach unter Einstellungen -> Allgemein -> Theme anpassen das folgende CSS einfügen. Dann wird der Lesebereich in drei Textblöcke unterteilt. Das funktioniert für mich richtig gut, und ich möchte gar nicht mehr ohne.

.content-inner { -webkit-column-count: 3; -moz-column-count: 3; column-count: 3; text-wrap: pretty; text-align: justify; hyphens: auto}Das ganze funktioniert auch mit freshRss. Hier gibt es unter Erweiterungen den Schalter User CSS.

.text { -webkit-column-count: 3; -moz-column-count: 3; column-count: 3; text-wrap: pretty; text-align: justify; hyphens: auto}Transparent Textures ist eine Seite, die transparente Hintergründe für die eigene Website inklusive dem passenden CSS zum Einbetten anbietet. Das Ganze ist so einfach wie nichts. Farbe und Hintergrund auswählen, CSS einbetten, fertig. Das gewählte Hintergrundbild sollte am besten noch irgendwo auf den eigenen Server oder eventuell bei GitHub und Konsorten kopiert werden, um nicht ohne coolen Hintergrund dazustehen, falls der Transparenttextures-Server mal down sein sollte.

Um das Hintergrundbild nun in Shaarli einzubinden, braucht man das Plugin shaarli-custom-css, das es einfach macht, ein paar Zeilen CSS einzuschleusen. Nach dem das Plugin installiert ist, kann man in der Plugin-Konfiguration das passende CSS von Transparent Textures einfügen. Damit das ganze auch funktioniert, muss noch die Body-Klammer drum herum. Dann hat man es komplett.

body {

background-color: #b3de81;

background-image: url("https://www.transparenttextures.com/patterns/arabesque.png");

}Links

https://www.transparenttextures.com/

https://github.com/immanuelfodor/shaarli-custom-css